Sie befinden sich im Archiv von ZU|Daily.

ZU|Daily wurde in die Hauptseite in den Newsroom unter https://www.zu.de/newsroom/daily/ integriert. Die neuesten Artikel seit August 2024 werden dort veröffentlicht. Hier finden Sie das vollständige Archiv aller älteren Artikel.

Max Webers später Triumph

Prof. Dr. Jan Söffner

Lehrstuhl für Kulturtheorie- und Analyse

- Zur PersonProf. Dr. Jan Söffner

Professor Dr. Jan Söffner, geboren 1971 in Bonn, studierte Deutsch und Italienisch auf Lehramt an der Universität zu Köln. Nach dem erfolgreichen Studienabschluss promovierte er am dortigen Romanischen Seminar mit einer Arbeit zu den Rahmenstrukturen von Boccaccios „Decamerone“. Die nächsten drei Jahre führten ihn als wissenschaftlichen Mitarbeiter an das Zentrum für Literatur- und Kulturforschung nach Berlin. Zurückgekehrt an die Universität zu Köln, erfolgte neben einer weiteren wissenschaftlichen Tätigkeit am Internationalen Kolleg Morphomata die Habilitation. Jan Söffner übernahm anschließend die Vertretung des Lehrstuhls für Romanische Philologie und Vergleichende Literaturwissenschaft an der Eberhard Karls Universität Tübingen und leitete Deutsch- und Integrationskurse für Flüchtlinge und Migranten an den Euro-Schulen Leverkusen. Zuletzt arbeitete er erneut am Romanischen Seminar der Universität zu Köln und als Programmleiter und Lektor beim Wilhelm Fink Verlag in Paderborn. An der Zeppelin Universität lehrt und forscht Professor Dr. Jan Söffner zur Ästhetik der Verkörperung, zur Kulturgeschichte sowie zu Literatur- und Theaterwissenschaften.

- Mehr ZU|DailyIntelligenz essen Seele aufWas passiert, wenn Maschinen immer mehr Macht übernehmen? Es droht das Ende der Menschheit. Vielleicht. ZU-Professor Jan Söffner hat sich über diese heißen Spekulationen Gedanken gemacht.Außer Kontrolle?Regelmäßig warnt Tesla-Chef Elon Musk: Künstliche Intelligenz sei gefährlicher als Atomwaffen. Berechtigte Panik oder Verweigerung vor dem Fortschritt – fragt sich auch ZU-Gastprofessor Hans Ulrich Gumbrecht.Entgeisterte WissenschaftenVor 60 Jahren kritisierte Charles Percy Snow, dass Natur- und Geisteswissenschaften in zwei völlig getrennten Kulturen lebten. Das hat sich geändert – doch dabei ist vieles verloren gegangen, kritisiert ZU-Professor Jan Söffner.

„Stellen Sie sich einen Flugzeugbauer vor, der Ihnen sagt: ,Nun, ich weiß nicht, weshalb dieses Flugzeug, das ich gebaut habe, sicher ist – eigentlich weiss ich nicht einmal, wie es überhaupt fliegt. Aber ich versichere Ihnen, dass nichts passieren kann.‘“ Als Nick Bostrom 2011 die ethischen Probleme der künstlichen Intelligenz mit diesen Worten veranschaulichen wollte, waren sie noch Gedankenspiel. Nur sieben Jahre später ist der Fall nicht mehr hypothetisch, und er betrifft bald so gut wie alle Flugzeuge.

Das derzeit modernste Flugsicherungssystem ist das ACAS X (Airborne Collision Avoidance System X). Es ist unter anderem eine Antwort auf die fatale Kollision von Überlingen, bei der das ältere, auf alle bis dahin erdenklichen Fälle hin manuell programmierte System TCAS (Traffic Alert and Avoidance System) versagte, was eine heftige Diskussion über die Verantwortung der Flugsicherungsgesellschaft Skyguide auslöste. Der Vater eines der Opfer ermordete daraufhin einen der Fluglotsen. ACAS X hätte die Kollision vermieden, weil es auf eine Art selbstlernender Software zurückgreift: Es befolgt nicht mehr eine endlose Liste menschlich entwickelter Regeln, sondern hat seine Regeln selbst entwickelt. Kurz: Auch die Entwickler dieser Software wissen nicht, warum nichts passieren kann.

Was mit solcher Software zu gewinnen ist, wird besonders deutlich, wenn man an ein anderes prominentes Einsatzgebiet selbstlernender Software denkt. Selbstfahrende Autos vermeiden unzählige Unfälle – dank niemals unachtsamen, niemals jähzornigen, niemals müden Computern, die auch nie aufs Smartphone schauen, weil sie sowieso schon online sind.

Nebenbei löst sich so – wie auch in der Flugsicherung – ein ganz anderes Problem: dasjenige der Verantwortung. Unfälle, die noch passieren, werden wirklich nur Unfälle sein, keine Straftaten. Es wird keine Leute geben, die betrunken ein Kind überfahren und darüber ihres Lebens nicht mehr froh werden – und keine Eltern, die diesen Leuten ihre Hölle auf Erden noch heißer machen: Was auf der Straße passiert, wird nicht mehr persönlich sein, sondern jenseits von Gut und Böse.

Damit ist die Ethik aber noch nicht ganz vom Tisch. Im Gegenteil. Je umfassender solche Steuerungstechnologie eingesetzt wird, desto mehr wird es zu Situationen kommen, bei denen zwischen zwei Übeln entschieden werden muss – einem toten Fußgänger und einem querschnittgelähmten Fahrer zum Beispiel. Auf diese Weise wird ein recht bekanntes ethisches Dilemma Realität, nämlich das sogenannte Weichenstellerproblem, das der Strafrechtstheoretiker Karl Engisch schon 1930 entwickelt hat.

Das Gedankenexperiment geht so: Stellen Sie sich vor, ein führerloser Eisenbahnwaggon rast auf fünf Menschen zu, die er ohne weiteres töten würde, wenn Sie, die Sie an einer Weiche stehen, nicht den Hebel umlegten. Dann nämlich rast er auf nur eine Person zu. Wenn Sie den Hebel betätigen, werden Sie also diesen einen Menschen töten – aber eben auch fünf Menschen retten. Nach ähnlichen Prinzipien minimiert selbstlernende Software den Schaden und findet die jeweils „beste“ Lösung.

Der eingangs zitierte Nick Bostrom plädiert dafür, künstliche Intelligenz nach ethischen Prinzipien zu programmieren und zu kontrollieren. Ihm selbst ist dabei bewusst, dass sich moralische Werte und Grundsätze wandeln und von Gesellschaft zu Gesellschaft sehr unterschiedlich sein können. Aber was bleibt uns anderes, so fragt er, als dieses Problem anzugehen und es softwaregerecht zu lösen, etwa durch Kriterien, die einen gewissen Relativismus zulassen. Das ist aber keine Lösung, denn das Problem geht tiefer.

Bemerkenswert klar und einfach formulierte es vor ziemlich genau hundert Jahren der deutsche Soziologe Max Weber in seiner Vorlesung „Politik als Beruf“, indem er für den politischen Raum zwei Formen der Verantwortung voneinander unterschied: Gesinnungsethik und Verantwortungsethik. Nur Erstere gründet auf moralischen Grundsätzen (wie eine Software sie frei nach Bostrom brauchen würde); doch als solche ist diese Ethik verantwortungslos, weil sie ihr Gutes oder Richtiges nicht an den Folgen, sondern an den Grundsätzen und Maximen des Handelns festmacht. Verantwortungsethiker dagegen sind für Weber nicht die ausführenden Organe von Prinzipien. Sie hängen nicht an den Fäden einer abstrakten Tugend, sondern müssen für die Konsequenzen dessen einstehen, was sie anderen tun: egal, welche Prinzipien sie befolgt haben.

Was Verantwortung konkret bedeutet und in welcher Hinsicht das Antworten-Müssen ein ethischer Imperativ sein kann, hat niemand besser auf den Punkt gebracht als der russisch-französische Philosoph Emmanuel Lévinas. Sein Fokus war das Gesicht des anderen Menschen, das mit dem Anspruch daherkommt, als ein Auch-Mensch angenommen zu werden. Da aber jeder Mensch für sich selbst genommen Zentrum und Ursprung einer Welt (der von diesem Menschen erlebten Welt) ist, ist dieser Anspruch kein einfacher, sondern ein unendlicher und absoluter, der nicht relativiert werden kann: Wer einem anderen Menschen antwortet und das eigene Tun auf ein solches Antworten-Können ausrichtet, verantwortet damit eine ganze Welt.

Sowohl für Weber als auch für Lévinas ist das eigentliche ethische Problem somit keines der Prinzipien, sondern eines der Verantwortung – und die Verantwortung ist gerade deshalb so wichtig, weil sie auch dann greift, wenn Prinzipien nicht helfen oder paradox werden. Konkret: Das oben zitierte Weichenstellerproblem ist für einen Verantwortungsethiker kein Dilemma. Für ihn stellt sich nicht die Frage, ob es richtiger sei, passiv fünf Personen zu töten oder aktiv eine. Der Punkt ist einzig der: Er weiß, dass er den Hinterbliebenen ins Gesicht sehen können muss.

Genau an diesem Punkt muss künstliche Intelligenz scheitern. Ein nach Bostroms Hoffnungen eingerichtetes selbstlernendes Programm würde in etwa so funktionieren wie eine ihre Gesetze bis in den kleinsten Absatz eines Paragrafen selbstgenerierende Verfassungspräambel – ohne legislative Kontrolle durch ein Parlament und ohne menschlichen Richter. Sie käme niemals in die Situation, für die Konsequenzen des eigenen Tuns geradestehen zu müssen, würde in den Konsequenzen ihrer Entscheidungen niemals auf sich selbst zurückgeworfen werden. Künstliche Intelligenz braucht Regeln, kann aber nichts verantworten, sie gehorcht Prinzipien und Maximen, muss aber für keinerlei Folgen einstehen: In dieser extremen Form hätte sich Weber eine Gesinnungsethik zu seiner Zeit noch kaum denken können.

Man kann einen solch späten Sieg der Gesinnungsethik über die Verantwortungsethik als Erleichterung empfinden, denn Verantwortung ist eine enorme Belastung. Die Welt hält ständig Überraschungen bereit und kommt mit Konsequenzen daher, an die man nicht gedacht hat, so dass man sich als Verantwortungsethiker – nach Weber – immer mit „diabolischen Mächten“ einlassen muss. Diese machen es teilweise erforderlich, ihnen auf ähnlich diabolische und unethische Weise entgegenzutreten, weil alles andere wirkungs- und damit verantwortungslos wäre. Sollte selbstlernende Software eine Verantwortungsethik zumindest simulieren können, dann dürfte sie dafür gerade nicht an ethische Prinzipien gebunden werden, sondern müsste frei walten können – was aber vollkommen unberechenbare Folgen haben könnte.

So gesehen wird auch klar, was man verliert, wenn man durch selbstfahrende Autos im Verkehr die persönliche Schuld und die persönliche Wut umgeht. Und so zeigt sich auch, was der alte philosophische Traum, die Welt durch ethische Prinzipien beschreiben und steuern zu können, eigentlich war: Es war der Traum von der Überwindung der Verantwortung, der Traum, die Konsequenzen von allem, was man tut, auf eine allgemeine Vernunft abladen zu können.

Genau dieser Traum wird nun, in der Analyse unendlicher Datenmengen, der Erstellung künstlicher Szenarien und dem Aufbau übermenschlicher selbstlernender Intelligenzen schleichend zur Realität. Es gibt kaum eine Chance, dass eine solche Übernahme der Ethik durch selbstlernende Software in die Schranken menschlicher Verantwortung gewiesen werden könnte: Entscheidungsträger, die auf intelligenter und zuverlässiger als sie selbst entscheidende Maschinen verzichten wollten, würden verantwortungslos handeln. Überlassen sie sich ihr aber, werden sie mit der Verantwortung die Grundlage des Ethischen ins Wanken bringen. Was danach kommt, ist kaum zu sagen, denn die Wege selbstlernender Software sind tief und unergründlich.

Dieser Beitrag ist am 21. Juni unter dem Titel „Die künstliche Intelligenz beschert Max Webers Gesinnungsethik einen späten Triumph“ in der Neuen Zürcher Zeitung erschienen.

Titelbild:

| Rock'n Roll Monkey / Unsplash.com (CC0 Public Domain) | Link

Bilder im Text:

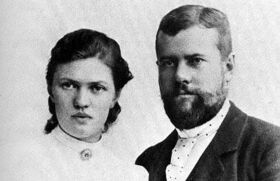

| Universität Marburg / Staff.Uni-Marburg.de (CC0 Public Domain) | Link

| Bram Van Oost / Unsplash.com (CC0 Public Domain) | Link

Beitrag (redaktionell unverändert): Prof. Dr. Jan Söffner

Redaktionelle Umsetzung: Florian Gehm